みなさんは、美術鑑賞、お好きですか?

先日、上野の、東京藝術大学の卒業・修了作品展、通称卒展に行ってきました。

diploma-works.geidai.ac.jp

毎年、藝大の卒業生が、集大成となる美術展示を、東京芸大と・お隣、東京都立美術館で展示する、というものになっています。

今回は、配信の音声では表現しきれなかった、展示作品についてのお話などを補足記事として残したいと思います。

open.spotify.com

今回、観にいこうと思ったきっかけ

以前のエピソードでもお話しした通り、2年前に、東京芸大に入学するまでを描く漫画、ブルーピリオドにどハマりしてから、美術館巡りが趣味の一つになりまして、毎年、自分自身の美術鑑賞の仕方や、作品の見方が変わってきている実感があります。

昨年、2023年には、ブルーピリオドがきっかけで知った「骨の博物館」や東京駅そばの「インターメディアテク」に訪れて、鑑賞者として展示を見つめること、自分の仕事や音声配信者として作品を見つめることの違い、を知りました。

open.spotify.com

note.com

また、2022年には、ブルーピリオドがきっかけで、箱根周辺の美術展を回った際に、作品を形容できないことの良さ、などをお話ししています(配信始めたての頃なので、配信に慣れてない感がありますが、ご愛嬌ということで)。

open.spotify.com

そんな、これまでの美術鑑賞を踏まえ、いつか行きたいと思っていた、卒展でしたが、ようやく訪れることができました。

今回は、この、藝大卒展の鑑賞通じて、自分が作品から感じたこと、巡らせた考えを、2024年の自分の鑑賞方法として、自分の思いを咀嚼し、対話をしてみたいと思います。

皆さんとの、鑑賞方法や視点の違い、新しい鑑賞のヒントになれば幸いです。

前編では、卒展の様子と、印象的だった作品をご紹介します。

卒展の印象

今回、会期が1/28から2/2までだったのですが、実は2回、観に行きました。

というのも、会場の広さもさることながら、圧倒的な作品数でしたので、一日では回れる広さ・数ではなかったためです。

正直、初めての参加かつ、普段の美術館鑑賞も2-3時間程度なので、舐めていたところもあったと思います。

休日と平日の二回に分けて、約9時間ぐらいかけ、藝大・都立美術館、両会場回ってきました。

平日・休日問わず、人手は多く、賑やかな様子が伺えました。

印象的だった作品

数百・数千とあった作品の中で、自分にとって印象的だった作品展示ですが、5つ紹介します。

(営利目的で作成した記事でないこと、僕自身が撮影してきた写真をもとに、作品の引用します。もし、掲載NGの場合は、記事から写真削除します)。

mother, father, sister, and I. (堀内万季子 さん)

(本記事筆者 撮影)

きっと、人の心が見えたら、それは奇妙で怖くて、でもどこか寂しげで、憎みきれないような、愛おしい姿になるんじゃないか。

作品説明より引用

「家族とは何か」に焦点を当てて制作したものです。

四体の大きな人形が、家族写真のように並んでいるが、それぞれの姿は異形そのもの。

ロボット、にクマのような毛皮を纏う怪物。もう一体は、昔の特撮の悪役幹部の魔女、もう一体は、無機質な人間の頭と関節からイソギンチャクのような触手が生えてている。

という印象を、タイトルを見る前に、僕は感じました。

全身は、白からクリーム色に近い色だが、輪郭や影は、冷め切った藍色で着色されており、異形のオーラが放つ、恐ろしさがあるが、どこか温かみがある、不思議な感覚。

タイトルを見て、これが家族の姿であることに納得しました。

七河豚神(森聖華さん)

(本記事筆者 撮影)

フグの七福神の陶器の展示で、口の中に願い事を書いた貝の紙を入れる。という作品です(配信では、作品名・作者失念しておりました…)。

展示のかわいさもありますが、願い事を作品に込めるという点で、新しい信仰が生まれる瞬間を見たな、と思いました。

きっと、この作品が、この先も日本のどこかに展示や奉納されたとしたら、きっと、誰かの願い(信仰)は、残り続けるだろうな、と感じる作品でした。

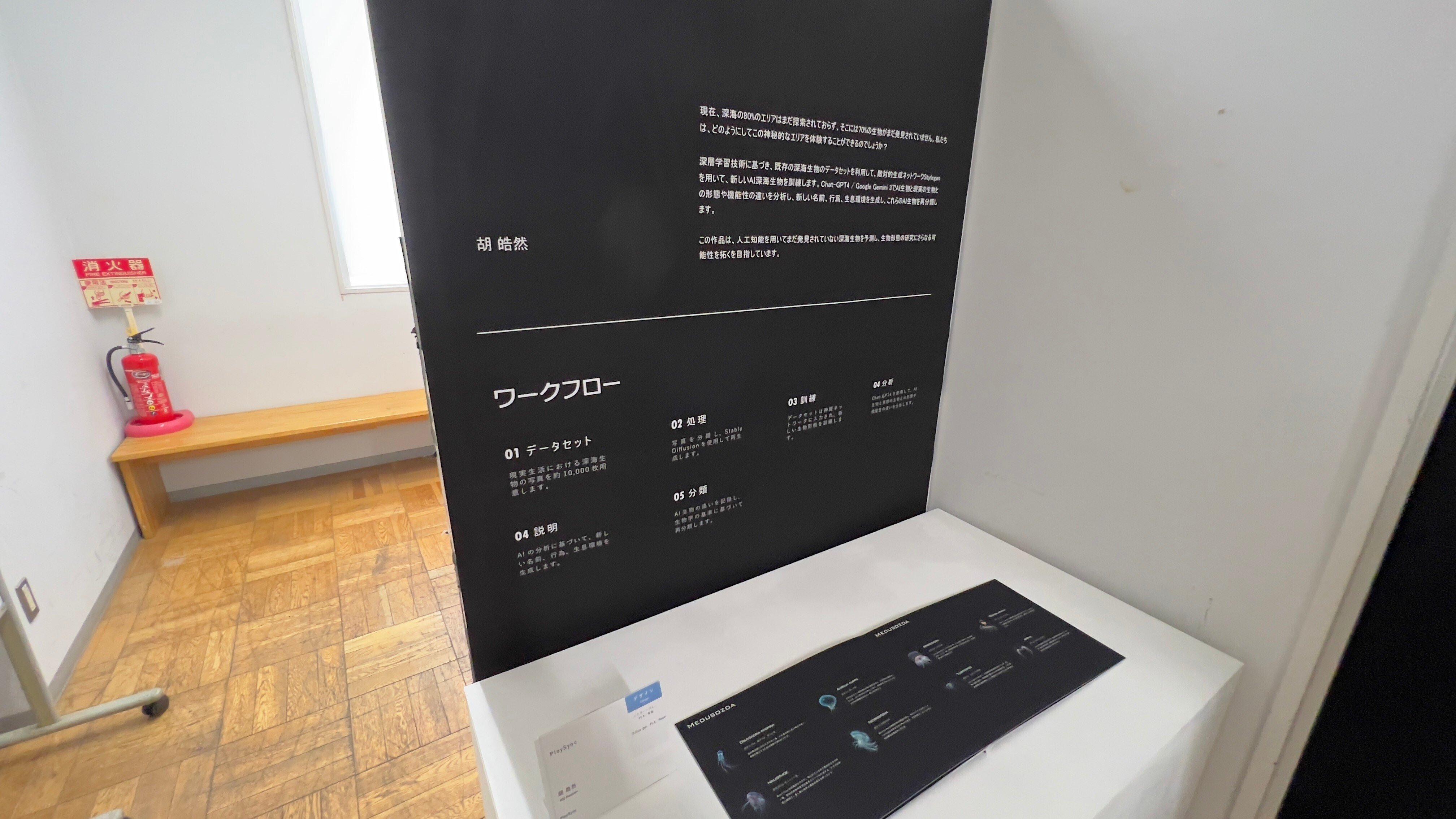

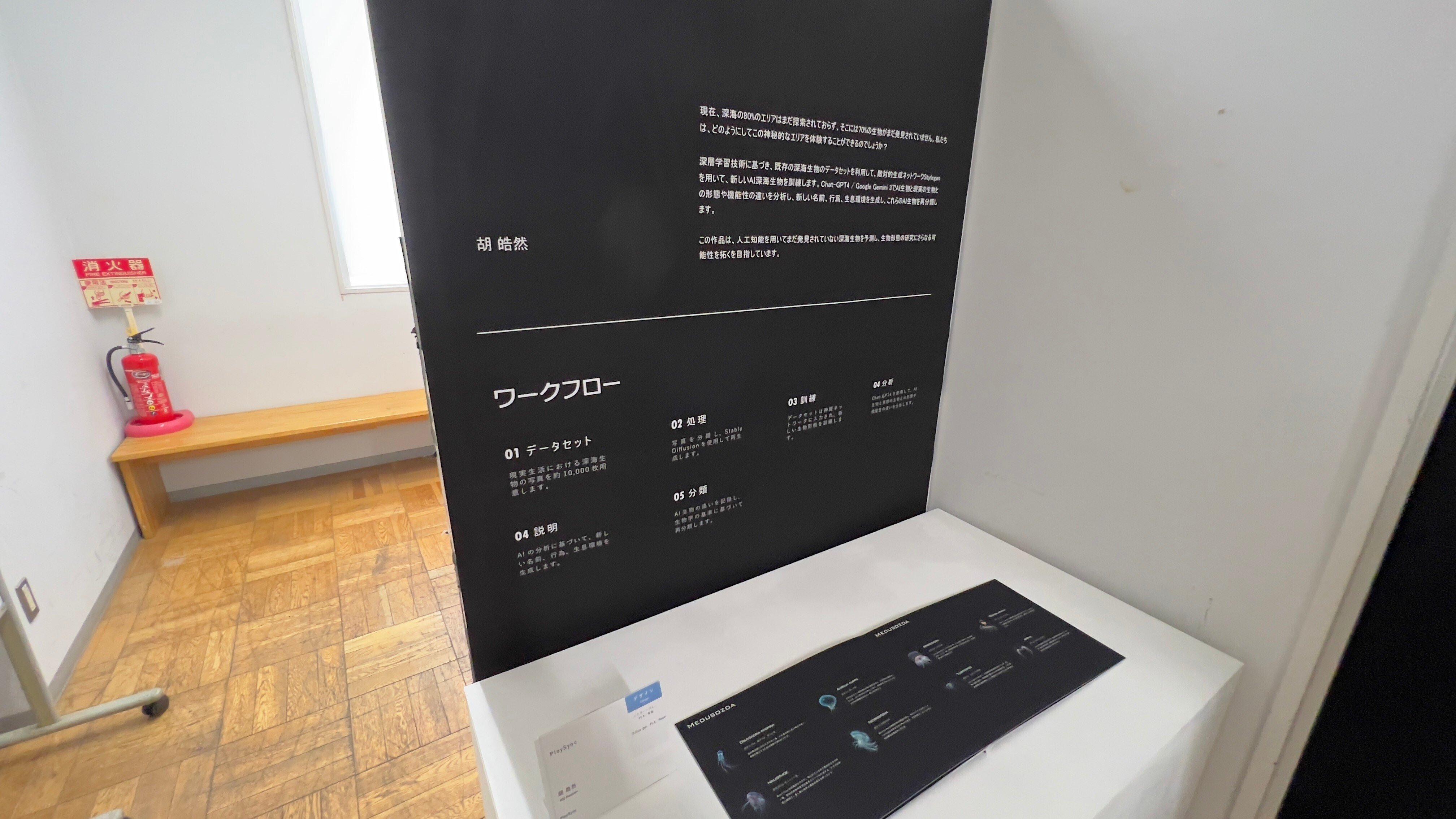

Play sync(胡皓然/ジャレン フー さん)

(本記事筆者 撮影)

(本記事筆者 撮影)

(本記事筆者 撮影)

深海のエリアの80%はまだ探索されておらず、70%の生物がまだ発見されていないので、既存の深海生物の写真1万枚をデータセットとしてAIを学習を学習し、新しい深海生物を作り、名前や行動、生息環境を、生物学の基準に照らして分類する、というものでした。

僕はこれまで、美術というものと、科学というものには、なんとなく距離がある、と思っていました。

美術というものは、これまでの美術史に基づくものであり、AIのような科学技術そのものはツールであり、美術の領域ではないと思っていたので、自分自身の偏見に気付かされた作品でした。

これ以外にも、ChatGPTや、画像生成AIを活用した物語を作品として展示されたいた方もおり、科学と美術の境界線は、自分自身が引いていたのだなと思いました。

皮膚を着る(北野歩実 さん)

(本記事筆者 撮影)

近い将来、自分好みの皮膚を着る時代がしたら、ということで、起こり得る未来を想像して提案する、という作品です。

制作した目的としては、人と異なることが受け入れるようになった現在でも、皮膚病や皮膚にあざや傷がある当事者にとっては、他人の目を気にすることがなくなっておらず、現代技術ではあまり想像につかない、未来を提案することで、皮膚病や未来について考える機会につなげたいということで、作成したそうです。

2050年、2080年、2100年の人工皮膚のデザインが提案されており、

2050年では、人肌に近い、人工皮膚を使用した服によって、皮膚病の人でも体への負担が少ない服

2080年では、自己修復する人工皮膚によって、形状を変えながら自己修復することで、人体に負担のかけない服

2100年では、イカやタコの擬態ように、皮膚の色を自由に変えられることで、他の人と違う皮膚の色を楽しむ服というものでした。

僕自身、Podcastで、未来を想像する、未来人が知りたい現代を音声として残す、ということもあり、シンパシーのようなものを、勝手に感じたため、印象的だった、ということもありますが、ありえるかもしれない未来を想像し、作品を作る、という作り方もあるんだ、ということが、自分にとっての新しい発見にもなってよかったなと思いました。

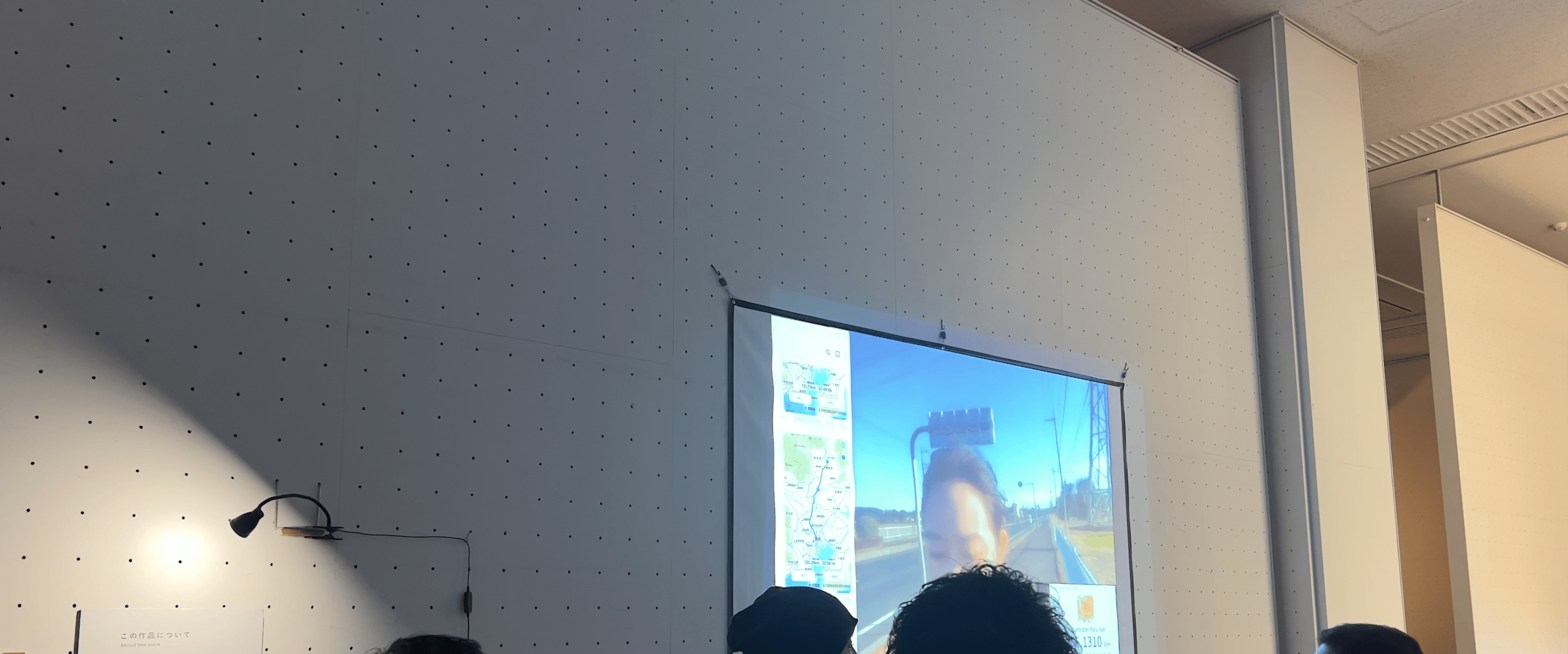

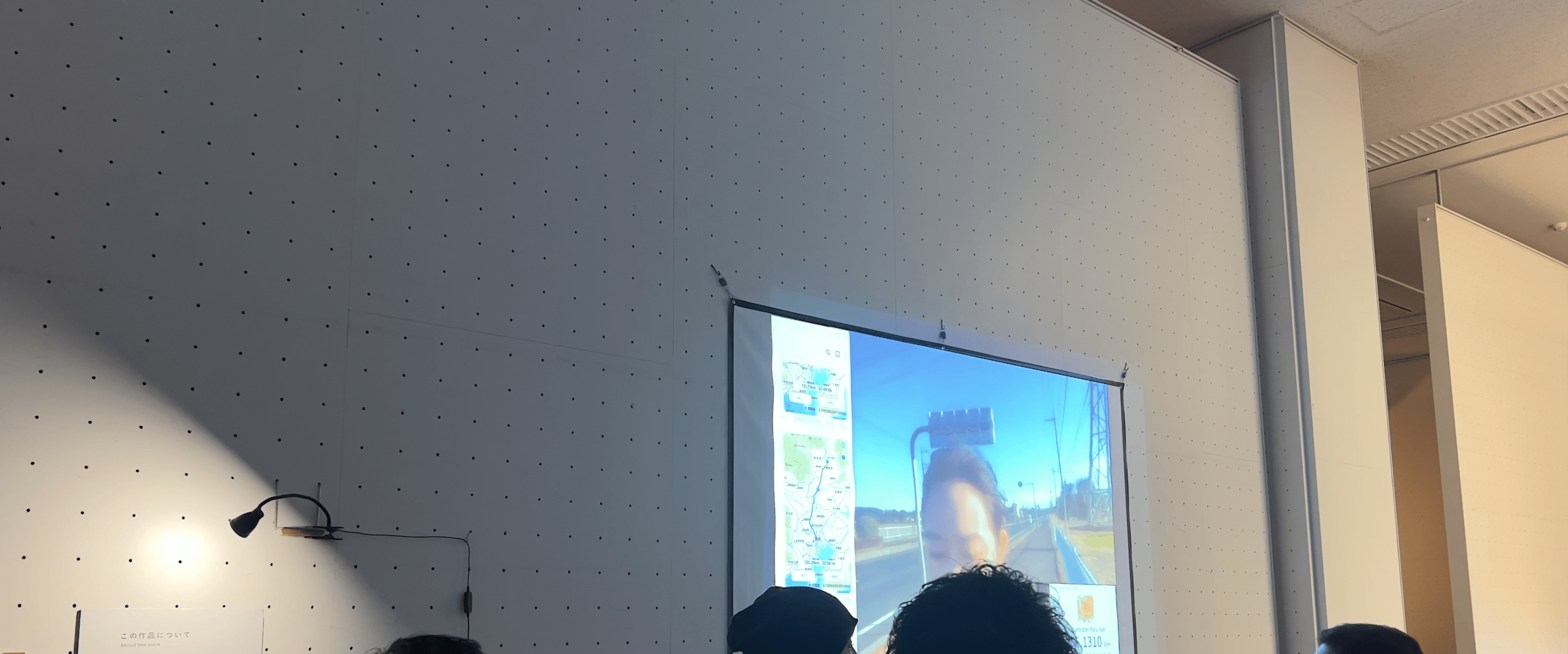

私のハムスターと、もう一つの旅(菅沼杏さん)

(本記事筆者 撮影)

(本記事筆者 撮影)

この展示期間中に、ペットのハムスターが回し車で走った距離を計測し、昼間に飼い主(=作者の菅沼さん)が同じ距離を移動するという、24時間リレー作品。

実際に、作者がライブ配信で、歩いている様子が配信されていて、会場から話しかけることができるというものでした。

この展示作品を見たときに感じたのは、表現が難しいのですが、展示されている状態は、完成(物理的な変更が終わる)のではない場合があるのだな、ということです。

絵を例に取ると、作品の完成ということには色々あると思います。

僕がこれまで見てきた作品のなかで、リアルタイムで刻々と変化する(鑑賞者が作品に干渉する/影響を与える)ものをみたことがなかったため、とても印象的でした。

まとめ

今回は、数ある作品の中から、僕自身が印象的だった作品をご紹介しました。

卒展、観に行けてよかったなと思いましたし、また来年も観に行きたいなと思います。

後編では、僕自身が、作品鑑賞の中で感じたこと、考えた当時のメモに基づきながら、自分自身の2024年の鑑賞を咀嚼・自己対話してみたいと思います。

後編のエピソードは以下です。

open.spotify.com

後編では、卒展での鑑賞中に、作品とは別で、鑑賞中に自身が感じたこと・考えたことのメモをもとに、2024年の自分自身の鑑賞に、目を向けてみています。

・これまでの鑑賞方法の遍歴

・作品との距離

・美術鑑賞が娯楽消費されているのでは、という違和感

・能動的鑑賞

・文化格差

・コロナ禍が作品に与えた影響は?

など、お話ししました。

みなさんの美術鑑賞の新しい視点・ヒントになれば幸いです。